Was ist Colocation?

Colocation Data Centers - auch bekannt als "Colo" - ist ein Servicemodell, bei dem Unternehmen Raum (Racks, Schränke, private Käfige oder eine ganze Datenhalle) in einem Rechenzentrum eines Drittanbieters mieten und ihre eigenen Server, Speicher und Netzwerkgeräte installieren. Der Anbieter stellt die gesamte Infrastruktur der Einrichtung zur Verfügung - Strom, Kühlung, physische Sicherheit und anbieterneutrale Netzanbindung -, während der Mieter die volle Kontrolle über seine Hardware und Software behält.

Colocation-Rechenzentren entstanden in den späten 1990er und frühen 2000er Jahren als Lösung für Unternehmen, die die kapitalintensive Last des Aufbaus und Betriebs ihrer eigenen Serverfarmen loswerden wollten. Zu dieser Zeit stieg die Nachfrage nach zuverlässigen Internetverbindungen und einer 24×7-Betriebszeit, aber der Aufbau einer vollständig redundanten Strom- und Kühlungsinfrastruktur war unerschwinglich teuer.

Colocation-Anbieter mieteten Rack-Flächen, Stromzufuhr und Netzwerkzugang in ihren Einrichtungen und ermöglichten es den Kunden, ihre eigene Hardware zu installieren und gleichzeitig von Skaleneffekten bei der Versorgung, Sicherheit und Konnektivität zu profitieren.

Die ersten Anwender waren vor allem ISPs und Dot-Com-Startups, aber Mitte der 2000er Jahre erkannten größere Unternehmen Colo als Möglichkeit, höhere Verfügbarkeits-SLAs zu erreichen, ohne Kapital zu binden, was zu einer explosionsartigen Zunahme von Carrier-neutralen "Meet-Me-Rooms" und Zusammenschaltungspunkten in wichtigen Metro-Märkten führte.

In den letzten zwei Jahrzehnten hat sich das Colocation-Geschäft weit über die einfache Vermietung von Raum und Strom hinaus entwickelt. Die Anbieter haben verwaltete Dienste - Remote Hands, Hardware-Überwachung und sogar komplettes Servermanagement - hinzugefügt und Colocation von einem "Bring-your-own-kit"-Modell in ein flexibles, bedarfsgerechtes Infrastrukturangebot umgewandelt.

Der Aufstieg von Cloud- und Hybrid-Cloud-Architekturen trieb weitere Innovationen voran, da Rechenzentren zu strategischen Konnektivitätszentren wurden, die direkte Anbindungen an AWS, Azure und Google Cloud bieten. In jüngster Zeit hat die steigende Nachfrage nach KI-Workloads und Edge-Computing Mikro-Kolos an 5G-Aggregationsstandorten und modulare Container-Bereitstellungen hervorgebracht, die Rechenleistung mit extrem niedriger Latenz näher an die Nutzer bringen.

Die heutige Colocation-Landschaft ist ein dynamisches Ökosystem, das herkömmliche Rackmieten mit DCaaS-Angeboten, Nachhaltigkeitsverpflichtungen und programmierbaren Verbindungsstrukturen verbindet - ein Zeichen dafür, wie sich die Branche kontinuierlich an die Anforderungen einer zunehmend digitalen und verteilten Welt angepasst hat.

Marktausblick für Colocation

Reines "Bring-your-own-servers, rent-a-rack"-Colocation bleibt ein großer und wachsender Markt, aber es ist nicht mehr das einzige Spiel in der Stadt. Hier ist, was passiert ist:

- Die Colocation selbst expandiert weiter

- Der weltweite Markt für reine Colocation-Einnahmen hatte einen Wert von etwa $69,4 Milliarden im Jahr 2024 und wird voraussichtlich auf $165,5 Milliarden bis 2030 zu einem 16 Prozent CAGR Grand View Forschung. Diese Zahlen konzentrieren sich speziell auf die reinen "Colocation"-Einnahmen, d. h. die Vermietung von Racks, Käfigen, Strom, Kühlung und grundlegenden Verbindungsdiensten. Managed Services, Value-Added-Edge- oder DCaaS-Pakete sind in der Regel nicht enthalten.

- Der globale Colocation-Markt, der ein breiteres Spektrum an "Infrastruktur-as-a-Service"-Colocation sowie DCaaS, Managed Hosting, Edge-Computing-Knoten und eng integrierte Konnektivität umfasst, wurde auf US$130,2 Milliarden im Jahr 2024 und wird voraussichtlich mit einer Wachstumsrate von 14,65 % CAGR bis 2034 und erreicht US$569,6 Milliarden GlobeNewswire.

- Aber höherwertige On-Demand-Modelle wachsen noch schneller

- Rechenzentrum als Dienstleistung (DCaaS)bei dem Sie vollständig verwaltete Rechen-, Speicher-, Netzwerk-, Stromversorgungs- und Kühlungsleistungen als Dienstprogramm mieten, stieg von $105,5 Milliarden im Jahr 2024 auf $127,4 Milliarden im Jahr 2025 und wird den Prognosen zufolge über $694 Milliarden bis 2034 zu einem 20,7 Prozent CAGR Vorrangige Forschung.

- Viele Colocation-Betreiber bieten jetzt "Rack plus alles andere" an - Managed Hands, DCIM, Sicherheits-/Compliance-Pakete und Cloud-Interconnect-Kredite - und verwischen damit die Grenze zwischen reinen Rack-Mieten und DCaaS Technavio.

- Hyperscaler und interessierte Unternehmen umgehen reines Colo vollständig

- Unternehmen wie Google, AWS und Meta bauen immer häufiger eigene Hyperscale-Campus oder mieten schlüsselfertige DCaaS-Kapazitäten, anstatt einfach nur Schränke in einer Halle mit mehreren Mietern zu mieten. Das Wall Street Journal.

- Beim Eintritt in neue geografische Regionen nutzen Hyperscaler jedoch häufig Colocation-Anbieter als erste Anlaufstelle, um Verfügbarkeitszonen schnell einzurichten und eine Präsenz aufzubauen, während die Nachfrage wächst. Dieser Übergangsansatz ermöglicht es ihnen, Arbeitslasten zu skalieren und den Markt zu evaluieren, bevor sie Kapital für die Planung und den Bau eines eigenen Rechenzentrums einsetzen.

- Es gibt eine klare Verschiebung weg von Kunden, die nur Rohraum + Strom + Kühlung. Stattdessen bündeln die meisten neuen Verträge verwaltete Dienste, verbrauchsabhängige Abrechnungund Cloud-/Edge-Integration.

- Wenn Sie eine Strategie für Ihr Rechenzentrum planen, sollten Sie davon ausgehen, dass reine Colo-Anlagen eine grundlegende Schicht bleiben werden - aber planen Sie auch höherwertige "As-a-Service"-Zusatzleistungen (DCaaS, Managed Colo, direkte Cloud-/Edge-Verbindungen) ein, die viele Kunden jetzt verlangen.

Wie Colocation funktioniert

Im Kern vereint Colocation die vier wesentlichen Säulen einer modernen Rechenzentrumseinrichtung - Raum und Strom, Kühlung und Umgebung, Konnektivität und Zusammenschaltung sowie Betriebsdienste -, so dass Unternehmen ihre eigene IT-Ausrüstung einsetzen und verwalten können, ohne die zugrunde liegende Infrastruktur selbst aufbauen oder betreiben zu müssen.

Die Mieter mieten einfach Schrank- oder Käfigflächen mit gemessenen, redundanten Stromzuführungen und lassen die USV, Generatoren und Kraftstoffreserven des Anbieters vor Ort die kontinuierliche Energieversorgung sicherstellen.

Präzisionskühlsysteme - von der Luftverteilung auf dem Doppelboden bis hin zu flüssigkeitsgekühlten Racks - sorgen für optimale Temperaturen und Luftfeuchtigkeit sowie für Effizienz und Zuverlässigkeit durch Kalt- und Warmgangeinhausung.

Carrier-neutrale Meet-me"-Räume ermöglichen Kunden den Anschluss an mehrere Netzwerke, Cloud-On-Ramps und Austauschpunkte für Verbindungen mit niedriger Latenz. Eine Reihe von Betriebsdiensten - Remote Hands, Cross-Connect-Bereitstellung, SLAs und Echtzeitüberwachung - runden das Angebot ab und sorgen für eine schlüsselfertige Umgebung, in der Ihre Server rund um die Uhr sicher und reibungslos laufen.

Die vier wichtigsten Säulen eines Colocation-Rechenzentrums

Raum & Macht

Gemietete Schränke mit redundanten Stromzuführungen

Kühlung und Umwelt

Präzisionskühlung und Einschluss von heißen/kalten Gängen

Konnektivität und Zusammenschaltung

Netzbetreiberneutraler Cross-Connect und IX-Zugang

Operative Dienste

Fernwartung, Verkabelung und SLA-gestützte Überwachung

- Raum & Macht

- Die Mieter mieten Standardschränke (42-48U), Half-Racks, Full-Racks, größere Käfige oder sogar kundenspezifische Open Compute Project (OCP)-Racks, die für High-Density- und Hyperscale-Implementierungen konzipiert sind. Jeder Raum verfügt über gemessene, redundante Stromzuführungen und dedizierte PDUs, die eine Vielzahl von IT-Anforderungen erfüllen.

- Die Anbieter unterhalten USV-Systeme, Notstromgeneratoren und Kraftstoff vor Ort, um eine kontinuierliche Energieversorgung zu gewährleisten.

- Kühlung und Umwelt

- In klimatisierten Räumen werden CRAC/CRAH-Geräte, Luftverteilung über den Boden oder Flüssigkeitskühlung für Racks mit hoher Dichte eingesetzt.

- Luftfeuchtigkeit, Luftstrom und Warm-/Kaltgänge werden nach OEM-Spezifikationen oder kundenspezifischen Anforderungen überwacht.

- Konnektivität und Zusammenschaltung

- Netzbetreiberneutrale "Meet-me-Räume" ermöglichen den Mietern eine Querverbindung zu mehreren Netzbetreibern, ISPs, Cloud-On-Ramps und Partnern.

- Viele Standorte beherbergen Internet Exchange Points (IXPs), die die Latenzzeiten und den Durchsatz für verteilte Anwendungen verbessern.

- Operative Dienste

- Ferngesteuerte Hände und Augen: Alltägliche Aufgaben (Racking, Verkabelung, Fehlerbehebung), die von Ingenieuren vor Ort durchgeführt werden.

- Querverbindungen und Verkabelung: Physische Verknüpfung von Mietsystemen mit Carriern, Clouds und anderen Kunden.

- SLAs und Überwachung: Gestaffelte Service-Levels für Stromversorgung, Netzverfügbarkeit und Reaktionszeiten.

Geschäftliche Vorteile von Colocation

Colocation-Rechenzentren bieten eine schlüsselfertige Plattform, die eine erstklassige Infrastruktur mit operativem Fachwissen kombiniert und es Unternehmen ermöglicht, hohe Verfügbarkeit, schnelles Wachstum und strenge Sicherheit zu erreichen - und das alles bei Kosten, die sich an der tatsächlichen Nutzung orientieren.

Durch die Anmietung von Raum und Strom in einer Carrier-neutralen Einrichtung profitieren Kunden von einer mehrstufigen Redundanz für unterbrechungsfreie Betriebszeiten, einer elastischen Skalierbarkeit, um Racks nach Bedarf hinzuzufügen, und einem verbrauchsabhängigen Opex-Modell, das hohe Investitionsausgaben vermeidet.

Robuste physische und netzwerktechnische Sicherheitsmaßnahmen - von biometrischen Zugangskontrollen und Videoüberwachung bis hin zu Firewalls und Feuerlöschanlagen der Unternehmensklasse - schützen kritische Anlagen, während sich die IT-Teams dank der Technik vor Ort und der Service-Level-Vereinbarungen auf Innovationen und nicht auf die Instandhaltung der Anlagen konzentrieren können.

Darüber hinaus sorgen integrierte Ökosysteme und softwaredefinierte "On-Ramps" zu Hyperscale Clouds sowie neue Edge-fähige Mikroeinrichtungen an 5G-Standorten für nahtlose Hybrid-Cloud- und Ultra-Low-Latency-Implementierungen für die anspruchsvollsten Anwendungen von heute.

- Zuverlässigkeit und Betriebszeit: Mehrstufige Redundanz (Stromversorgung, Kühlung, Netzwerk) gewährleistet branchenführende Verfügbarkeit

- Skalierbarkeit: Schnelle Kapazitätserweiterung - fügen Sie einfach Racks hinzu oder stellen Sie mehr Platz zur Verfügung - ohne kapitalintensive Baumaßnahmen.

- Kosteneffizienz: Das OpEx-Modell vermeidet große Vorabinvestitionen; die Abrechnung erfolgt verbrauchsabhängig (Platz, Strom, Bandbreite).

- Physische und Netzwerksicherheit: Biometrischer Zugang, CCTV, Brandbekämpfung und Firewalls für Unternehmen.

- Konzentration auf das Kerngeschäft: Übertragen Sie das Gebäudemanagement an Experten und setzen Sie IT-Mitarbeiter für umsatzfördernde Projekte frei.

- Ökosystem und Zusammenschaltung: Die Nähe zu Cloud-Anbietern, Partnern und Carrier-Hubs beschleunigt Hybrid-Cloud-Bereitstellungen.

Neben den klassischen Vorteilen bietet die moderne Colocation heute auch andere Vorteile:

- Digitale Ökosysteme und Startrampen: Sofortige Konnektivität zu Hyperscale Clouds und SaaS über softwaredefinierte Verbindungsplattformen

- Edge-Ready-Einsätze: Mikroeinrichtungen, die an 5G-Basisstationen angesiedelt sind und extrem niedrige Latenzzeiten für IoT/AR/VR bieten - und damit die Rolle von Colo im Edge Computing stärken.

Energieleistung und Zuständigkeiten

Wenn man die Verantwortung für die "Eingeweide" einer Einrichtung (Strom, Kühlung, Gebäude) von den "Gehirnen" (Server, Speicher, Netzwerk) trennt, wird das Erreichen von ganzheitlichen Energie- und Nachhaltigkeitszielen komplexer - aber die Branche hat sowohl Governance-Modelle als auch Tools entwickelt, um diese Kluft zu überbrücken.

Die Herausforderung der geteilten Zuständigkeit (Shared-Responsibility)

Bei einer typischen Colo-Bereitstellung:

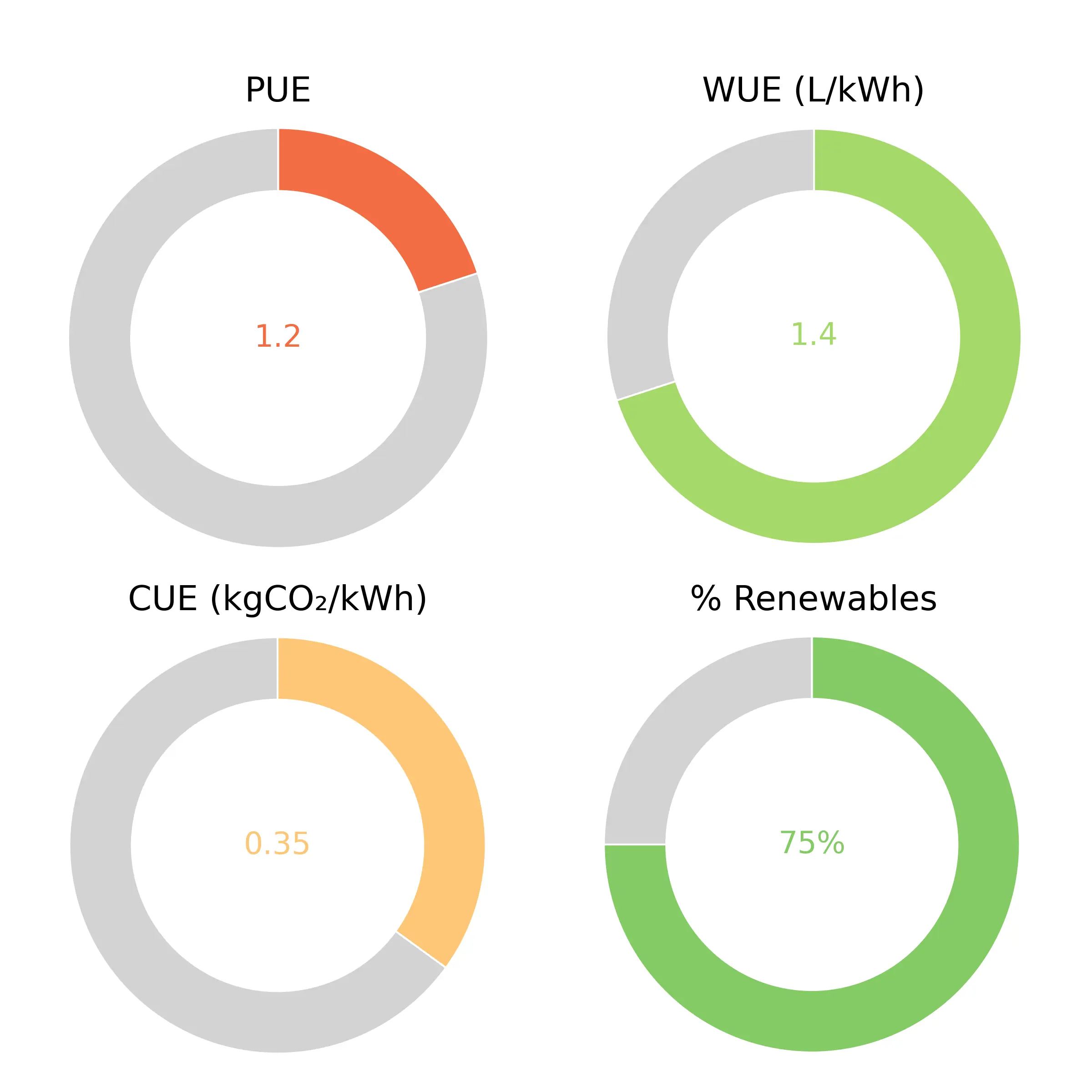

- Anbieter besitzt und optimiert die mechanischen Anlagen - Klimageräte, Kältemaschinen, Generatoren, USV - und kontrolliert so den PUE-Wert (Power Usage Effectiveness), den WUE-Wert (Water Usage Effectiveness) und den Basis-CUE-Wert (Carbon Usage Effectiveness) der Einrichtung

- Mieter installiert und verwaltet IT-Geräte, die sich in Bezug auf Leistungsdichte, Nutzung und Lebenszykluseffizienz stark unterscheiden können. Dieser IT-Fußabdruck hat direkten Einfluss auf die IT-Seite von PUE und CUE, liegt aber außerhalb der direkten Kontrolle des Anbieters.

Zusammenfassend lässt sich sagen, dass die zusammengesetzte PUE/CUE/WUE Die tatsächlich erreichte Leistung hängt von den Handlungen beider Parteien ab, so dass die End-to-End-Leistung schwerer zu garantieren ist.

Governance und Transparenz durch SLAs und Dashboards

Um diese geteilte Verantwortung zu bewältigen, haben führende Colo-Anbieter die Nachhaltigkeit in ihre Verträge und Kundenportale aufgenommen:

- Energieeffiziente SLAs: 74 % der Anbieter berichten, dass die Kunden "vertraglich verbindliche Effizienz- und Nachhaltigkeitsverpflichtungen" erwarten, mit ausdrücklichen PUE-Zielen oder Kohlenstoffobergrenzen in den Mietverträgen.

- Unterzählung und Berichterstattung: Mieter können sich für Submeter pro Rack oder pro Käfig entscheiden, die die Dashboards beider Parteien speisen. So kann ein Unternehmen genau sehen, wie viel M&E (mechanische und elektrische) Gemeinkosten im Vergleich zur IT-Last sie verbrauchen.

- Dashboards zur Nachhaltigkeit: Das Beispiel-Nachhaltigkeits-Dashboard zeigt PUE-, WUE-, CUE- und prozentuale Erneuerbare-Energien-Kennzahlen für jede Einrichtung in Echtzeit an - als intuitive Anzeigen, die sofort erkennen lassen, wo Effizienzgewinne oder Risiken liegen. Durch die Darstellung des Energie- und Wasserverbrauchs, der Kohlenstoffintensität und des Anteils erneuerbarer Energien vor Ort in einem einzigen Fenster können Anbieter und Mieter gemeinsam die Leistung überwachen und über die Ziele für Scope 1, Scope 2 und teilweise Scope 3 berichten.

Ein weiteres Beispiel für ein Nachhaltigkeits-Dashboard könnte den Stromverbrauch pro Standort, die Kohlendioxidemissionen (standort- und marktbezogen) und den Anteil der erneuerbaren Energien aufzeigen und damit die gemeinsame Überwachung und Berichterstattung zu den Bereichen 1, 2 und teilweise 3 ergänzen.

Was der Markt verlangt

Unternehmen - insbesondere im Finanzwesen, im Einzelhandel und in der öffentlichen Verwaltung - stehen unter wachsendem Druck durch Vorschriften und bei der Beschaffung:

- Wissenschaftlich fundierte Ziele erreichen (z.B. Netto-Null bis 2030).

- Zertifizierung über Standards Dritter (ISO 50001, ISO 14001, LEED, BREEAM).

- Konsequent berichten durch CDP, TCFD oder regionale Rahmenwerke wie die EU-Richtlinie zur Nachhaltigkeitsberichterstattung von Unternehmen (CSRD).

- Erneuerbare Energien beschaffen über Stromabnahmevereinbarungen (PPA) oder grüne Tarife.

Da die Mieter den Kohlenstoffmix der Einrichtung nicht selbst garantieren können, bestehen sie jetzt darauf, dass die Colo-Anbieter entweder erneuerbare Energien vor Ort, PPAs oder "grüne Bescheinigungen" als Teil ihres Mietvertrags anbieten.

Aufstrebende Lösungen und Innovationen auf der Service-Schicht

Die Anbieter haben darauf mit einem wachsenden Angebot an auf Nachhaltigkeit ausgerichteten Funktionen reagiert:

- Berichterstattung über erneuerbare Energien: Gebündelte PPAs, virtuelle PPA-Angebote oder direkte Solar-/Windkraftanlagen vor Ort. Equinix, Digital Realty und andere bieten ihren Kunden jetzt die Möglichkeit, 100 % an erneuerbaren Energien für ihren Standort "festzuschreiben" (Business Insider).

- KI-gesteuerte Optimierung: Das KI-Tool Apollo von Digital Realty analysiert in Echtzeit sowohl die Lasten der Gebäude als auch die der Mieter, um die Sollwerte für die Kühlung, den Einsatz der Batterien und sogar den Betrieb des Mikronetzes auf Standortebene zu optimieren und so die Emissionsreduzierungsziele von 60 % bis 2030 zu erreichen (Business Insider).

- Verwaltete IT- und Orchestrierungsebenen: Neben der reinen Rack-Fläche bieten die Betreiber jetzt auch "Full-Stack"-Rack-Einheiten an, in denen sie Server und Virtualisierung im Namen des Kunden verwalten und so das gesamte PUE/CUE/WUE-Bild wieder unter ein Dach bringen.

- Programme für die Kreislaufwirtschaft: Die Rücknahme von Geräten, das Recycling von Elektroschrott und Angebote für wiederaufbereitete Hardware helfen den Mietern, den Kohlenstoffgehalt ihrer IT-Flotten zu reduzieren.

Unterm Strich:

Auch wenn reine Colo-Anlagen naturgemäß die Verantwortlichkeiten trennen, ist die Richtung der Branche klar: gemeinsam verwaltete SLAs, transparente Dashboards und integrierte Nachhaltigkeitsdienste werden zur Selbstverständlichkeit. Unternehmen haben nach wie vor die Kontrolle über ihren Compute-Stack, aber beide Seiten teilen nun Daten, Ziele und sogar Tools, um sicherzustellen, dass Energie-, Wasser- und Kohlenstoffmetriken durchgängig kontrolliert, geprüft und als einheitliches Ergebnis optimiert werden können.

Modernste Kolokation

Um mit dem sich entwickelnden Colocation-Markt Schritt zu halten, definieren führende Anbieter neu, was es bedeutet, zu kollokieren. Von umweltfreundlichen Konstruktionen und KI-gesteuerten Abläufen bis hin zu Edge-zentrierten Mikroanlagen und souveränen Enklaven - diese Innovationen sind nicht nur Schnickschnack, sondern stellen sich den dringenden Herausforderungen in Bezug auf Nachhaltigkeit, Latenz, Sicherheit und regulatorische Komplexität, denen sich moderne Unternehmen stellen müssen.

Hier erfahren Sie, wie die Rechenzentrumsbranche grünen Beton und Microgrids einsetzt, maschinelles Lernen in jede Facette des Gebäudemanagements einbettet und hybride Cloud-Fabrics miteinander verknüpft - und so ein neues Maß an Effizienz, Widerstandsfähigkeit und Leistung für unternehmenskritische Workloads erreicht.

Nachhaltigkeit und grünes Bauen

Das Rechenzentrum von Meta in Rosemount, Minnesota, ist führend in der AI-optimierter grüner BetonDas Projekt nutzt die Open-Source-Frameworks BoTorch und Ax von Meta, um multikriterielle Bayes'sche Optimierungen für Tausende von Mischungsvarianten durchzuführen und kohlenstoffarme Rezepturen zu ermitteln, die die strukturelle Integrität erhalten und gleichzeitig die CO₂-Emissionen im Vergleich zu herkömmlichem Beton um bis zu 30% senken.

Parallele akademische Arbeiten haben die Leistungsfähigkeit von Conditional Variational Autoencoders (CVAEs) demonstriert, um kundenspezifische Betonrezepte aus begrenzten Datensätzen mit Auswirkungen auf den Lebenszyklus zu generieren und so den Übergang von Modellen im Labormaßstab zu Güssen in vollem Umfang innerhalb von Wochen statt Monaten zu beschleunigen - ein entscheidender Faktor für Hyperscale- und Edge-Einsätze, bei denen sowohl Geschwindigkeit als auch Nachhaltigkeit eine Rolle spielen (Technik bei Meta, arXiv).

Zusammen mit umweltfreundlicheren Baumaterialien, Erneuerbare Energien vor Ort und modulare Mikronetze gestalten die Energiebilanz von Colocation neu. Betreiber kombinieren nun PV-Solaranlagen, Brennstoffzellen oder Biogasgeneratoren mit Batteriespeichern und intelligenten Steuerungen, um bis zu 80% Scope-2-Emissionen auszugleichen und gleichzeitig die Widerstandsfähigkeit bei Netzstörungen zu erhöhen.

Gleichzeitig bieten Branchenrahmen wie der "Guide to Environmental Sustainability Metrics for Data Centers" des Uptime Institute und sich entwickelnde Methoden des GHG-Protokolls wie der 24/7-Kohlenstoffabgleich Anbietern und Mietern die nötige Transparenz, um Scope-2- und Scope-3-Emissionen in Echtzeit zu verfolgen und bis 2030 einen "nahezu kohlenstofffreien" Betrieb zu zertifizieren.

In Verbindung mit KI-gesteuerten Energiemanagementplattformen, die aktiv die Kühlsollwerte anpassen und die Stromverteilung optimieren, ermöglichen diese Fortschritte Colocation-Einrichtungen, ehrgeizige PUE-, WUE- und CUE-Ziele zu erreichen und gleichzeitig den Kunden messbare Nachhaltigkeitsergebnisse zu liefern.

Edge-Ready Colocation und 5G-Integration

Edge-Ready-Colocation bringt Rechen- und Speicherleistung buchstäblich vor die Haustür des Netzwerks. Dabei werden Mikro-Rechenzentren in oder neben 5G-Funkzugangsknoten eingebettet, sodass IoT-Sensoren, AR/VR-Headsets und Echtzeit-Analyse-Engines über Verbindungen im einstelligen Millisekundenbereich mit der Verarbeitungsinfrastruktur kommunizieren können.

Analysten berichten mindestens 1.500 Pilotprojekte für Edge-Rechenzentren weltweit bis 2023und unterstreicht damit die rasche Reifung dieses verteilten Modells (GlobeNewswire). Die Website Globaler Markt für Edge-Rechenzentrenmit einem Wert von etwa $6 Milliarden US-Dollar im Jahr 2023 und wird voraussichtlich auf US$17 Milliarden bis 2032 zu einem 12,5 % CAGRspiegelt die Tatsache wider, dass sowohl Hyperscale- als auch Colo-Betreiber um die Errichtung von Mikroanlagen ringen, die die strengen Anforderungen von 5G an Latenz und Bandbreite erfüllen (DatenIntelo).

Partnerschaften zwischen Telekommunikationsunternehmen und Standortbetreibern aus der Praxis zeigen, wie Edge-Integrationen neue Servicemodelle freisetzen. In den Vereinigten Staaten, Dish Drahtlos hat in wichtigen Märkten Edge-Rechenzentren vor Ort eingerichtet, um Open RAN-Funktionen und MEC-Workloads zu hosten und sie über ein dediziertes Hochgeschwindigkeits-Backbone miteinander zu verbinden, um eine Leistung von unter 10 ms für Anwendungen wie Live-Videoanalyse und Smart-Factory-Steuerung zu gewährleisten (Cisco).

Diese Kooperationen sind ein Beispiel dafür, wie Colocation-Anbieter und Carrier gemeinsam optimierte Edge-Angebote entwickeln, die extrem niedrige Latenzzeiten, lokale Ausfallsicherheit und eine vereinfachte Integration in breitere Hybrid-Cloud- und Multi-Access-Edge-Computing-Ökosysteme (MEC) bieten.

KI-gesteuerte Abläufe und vorausschauende Analysen

Rechenzentren erzeugen heute riesige Telemetriedatenströme - von der Stromaufnahme auf Rack-Ebene und den Ein- und Austrittstemperaturen bis hin zu Luftstromgeschwindigkeiten und Gerätevibrationen. KI-gesteuerte DCIM-Plattformen nehmen diesen kontinuierlichen Datenstrom auf und wenden Machine-Learning-Modelle und Algorithmen zur Erkennung von Anomalien an, um subtile Abweichungen zu erkennen, lange bevor sie zu Ausfällen führen.

In ähnlicher Weise analysiert die Apollo AI-Plattform von Digital Realty Strom-, Kühl- und Umgebungsdaten in der gesamten globalen Niederlassung, um die CRAC-Sollwerte und die Kompressoranordnung dynamisch zu optimieren, was zu Echtzeit-PUE-Verbesserungen von 5-7% und einer Senkung des Kühlenergieverbrauchs um bis zu 8% bei Spitzenlasten führt (digitalrealty.com).

Die breitere AIOps-Bewegung zeigt, dass intelligente Überwachung die Mean Time to Detect (MTTD) um 15-20% verbessern und kritische Vorfälle um mehr als 50% reduzieren kann, was insgesamt zu einer Senkung der Energie- und Betriebskosten im Rechenzentrumsbetrieb um 5-10% führt.

Durch die Einbettung von prädiktiven Analysen in Alarme, Workflow-Orchestrierung und automatisierte Abhilfemaßnahmen können moderne Colocation-Anbieter höhere SLAs für die Betriebszeit und konsistentere PUE-Ziele garantieren. Erste Anwender berichten von weniger ungeplanten Ausfällen, längeren Lebenszyklen der Anlagen und einer Verschlankung des Betriebspersonals, so dass sich die technischen Teams auf Kapazitätsplanung und Service-Innovation konzentrieren können, statt sich um die Brandbekämpfung zu kümmern.

Modulare und containerisierte Rechenzentren

Vorgefertigte, auf Skids montierte und in Containern untergebrachte Rechenzentren haben die Bereitstellungszeiten revolutioniert, indem sie das, was früher Monate dauerte, auf nur wenige Wochen verkürzen. Nach Angaben von Research and Markets via GlobeNewswire wurde der globale Markt für vorgefertigte und modulare Rechenzentren auf einen Wert von US$4,24 Milliarden im Jahr 2024 und wird voraussichtlich mit einem Wachstum von 15,39 % CAGR zu erreichen US$17,76 Milliarden bis 2034 (GlobeNewswire).

Diese Container-Einheiten bündeln Racks, Stromverteilungseinheiten und integrierte Flüssigkeitskühlkreisläufe in einer einzigen "Plug-and-Play"-Hülle. Auf der Stromseite werden vorgefertigte elektrische Schlitten-komplett mit USV-Modulen, Schaltanlagen und Batteriespeichern- werden werkseitig getestet und fertig für den schnellen Anschluss vor Ort geliefert, wodurch die Komplexität der Koordinierung mehrerer Gewerke entfällt (pcxcorp.com).

Interkonnektivität der Hybrid Cloud

Diese direkten Verbindungen vereinfachen hybride IT-Architekturen, da keine separaten privaten WAN-Verbindungen für jeden Anbieter verwaltet werden müssen und die Verbindungsdienste innerhalb des Rechenzentrums zentralisiert werden (CoreSite Erfahrung).

Gemeinsam sorgen diese Innovationen dafür, dass Mieter ihre Workloads nahtlos zwischen ihren eigenen Racks, Edge Colos und Hyperscale Clouds verschieben können, und zwar mit Leistung, Sicherheit und Verwaltbarkeit auf Unternehmensniveau.

Datensouveränität und Einhaltung gesetzlicher Vorschriften

Hinzu kommen die bevorstehenden EU-KI-GesetzDazu kommen nationale Gesetze zur "Cloud-Souveränität" (z. B. das deutsche Cloud-Strategie-Gesetz oder das chinesische Multi-Level-Protection-Scheme), die vorschreiben, dass die Daten innerhalb der jeweiligen Landesgrenzen bleiben müssen.

Um diesen sich überschneidenden Anforderungen gerecht zu werden - und um den Kunden das Vertrauen in die Einhaltung der Vorschriften zu geben - bieten die Betreiber von Kolos jetzt spezielle Lösungen für die digitale Souveränität" an, die den Verbleib der Daten, die Überprüfbarkeit und die Anpassung an die Vorschriften garantieren.

- Souveräne Enklaven - Physisch und logisch isolierte Käfige oder Pods mit separater Stromzufuhr, Schlüsselverwaltungsdiensten und dedizierten Netzwerken stellen sicher, dass sensible Arbeitslasten niemals mit den Daten anderer Mieter vermischt werden (CoreSite).

- On-Shore-Clouds & EUCS-Zertifizierung - Einige Betreiber gehen Partnerschaften mit lokalen Behörden oder Cloud-Plattformen ein, um national verwaltete Clouds bereitzustellen (z. B. Azure Deutschland, AWS Europe-Zürich, Oracle Frankreich), die häufig unter dem EU-Regelung für Cloud-Dienste (EUCS) für Basissicherheit und Interoperabilität (JD Supra).

Indem sie diese Funktionen in Colo-Angebote integrieren, schließen Anbieter die Lücke zwischen den Verantwortlichkeiten auf Standortebene (PUE, physische Sicherheit) und der IT-Governance auf Mieterebene.

Zusammenfassung der Sektion

Zusammenfassend lässt sich sagen, dass sowohl Betreiber als auch Mieter über die traditionellen CapEx- und OpEx-Kalkulationen hinausblicken müssen, um den gesamten wirtschaftlichen und ökologischen Fußabdruck ihrer Installationen zu erfassen.

Moderne TCO-Modelle (Total Cost of Ownership) berücksichtigen jetzt auch Kohlenstoffabgaben, Netzzugangs- und Verbrauchsgebühren und sogar Wasserverbrauchskosten, so dass Entscheidungen über Standort, Versorgungsverträge und Anlagendichte sowohl finanzielle als auch Nachhaltigkeitsziele berücksichtigen.

Gleichzeitig gewinnen Strategien der Kreislaufwirtschaft - wie die Wiederaufbereitung von IT-Geräten, die Wiederaufbereitung von Komponenten und Recycling-Programme am Ende der Lebensdauer - an Bedeutung, die es Rechenzentren ermöglichen, Materialkreisläufe zu schließen, den gebundenen Kohlenstoff zu reduzieren und die Menge an Elektroschrott zu verringern, während sie gleichzeitig ihre Kernbestände über mehrere Hardware-Lebenszyklen hinweg erhalten.

An der Technologiefront ist ein tieferes Verständnis der Workload-Profile entscheidend. GPU-lastige KI-Trainingscluster erfordern eine konstante High-Density-Leistung und eine robuste Flüssigkeitskühlung, während Analysepipelines mit hoher Auslastung eher von flexibler Rack-Bereitstellung und dynamischer VM-Orchestrierung profitieren.

Neben der Überwachung der Stromverbrauchseffektivität (PUE) messen führende Einrichtungen jetzt auch die Wassernutzungseffektivität (WUE), um Verdunstungs- und adiabatische Kühlstrategien zu optimieren und die Ressourceneffizienz weiter zu steigern.

Schließlich haben sich Digital-Twin-Simulationen als leistungsfähiges Planungsinstrument erwiesen, das es den Betreibern ermöglicht, Kühlungsluftströme, Stromverteilungskontingente und Katastrophenszenarien virtuell zu modellieren, Kapazitätserweiterungen vor dem ersten Spatenstich zu validieren und Fehlerreaktionsübungen zu proben, ohne die Schaltanlage jemals anzufassen.

Zusammen bilden diese Erkenntnisse die Grundlage für eine wahrhaftige Colocation-Strategie der nächsten Generation, die finanziell transparent, umweltbewusst und streng auf die Anforderungen der modernen IT ausgerichtet ist.

Auswahl eines Colocation-Anbieters

Bei der Auswahl des richtigen Colocation-Anbieters geht es um mehr als nur um die Sicherung von Stellflächen - es geht darum, einen Partner zu finden, dessen Infrastruktur, Dienstleistungen und Verpflichtungen mit Ihren Zielen in Bezug auf Leistung, Sicherheit und Nachhaltigkeit übereinstimmen.

Von geografischer Ausfallsicherheit und Konnektivität mit niedriger Latenz bis hin zu strengen Compliance-Zertifizierungen und transparenten SLAs - jeder Aspekt trägt zur Zuverlässigkeit und Kosteneffizienz Ihrer Bereitstellung bei. Im Folgenden finden Sie die wichtigsten Faktoren, die Sie bei der Auswahl eines Anbieters berücksichtigen sollten, der sowohl Ihre aktuellen Anforderungen als auch zukünftiges Wachstum unterstützt.

- Standort und Nähe: Auswirkungen von Latenzzeiten, Naturkatastrophen und Anforderungen an Regulierung und Datensouveränität.

- Konnektivitätsoptionen: Anzahl der Betreiber, direkte Cloud-Verbindungen (z. B. AWS Direct Connect, Azure ExpressRoute).

- Zertifizierungen und Konformität: ISO 27001, SSAE 18, PCI DSS, HIPAA, GDPR/CSRD Bereitschaft.

- Dienstgüte und Transparenz: SLAs für PUE-Ziele, Netz- und Stromverfügbarkeit, Reaktionszeiten.

- Nachhaltigkeitsverpflichtungen: Berichterstattung über PUE/WUE/CUE, den Anteil der erneuerbaren Energien und die Ziele der Klimaneutralität.

- Ferngesteuerte Hände & DCIM: Verfügbarkeit von Vor-Ort-Support und Integration mit Verwaltungstools für die Infrastruktur des Rechenzentrums.

Zukünftige Trends

Die Rechenzentrumsbranche entwickelt sich weiterhin in rasantem Tempo. Eine neue Welle von Innovationen wird die Art und Weise, wie Unternehmen ihre Infrastruktur nutzen und sichern, neu definieren. In den kommenden Jahren werden vollständig verwaltete KI- und Rechenzentrumsservices zu nahtlosen On-Demand-Angeboten verschmelzen, während Zero-Trust-Architekturen Identitäts- und Least-Privilege-Kontrollen in jede Betriebsebene einbauen werden.

In der Zwischenzeit wird 5G-natives Network Slicing eine vorhersehbare Leistung für latenzempfindliche Workloads garantieren, und "Nachhaltigkeit als Service" wird Umweltverantwortung von einem Marketingversprechen in eine messbare, SLA-gestützte Realität verwandeln.

- AIaaS & DCaaS Konvergenz: Vollständig verwaltete Rack-to-AI-Pipelines, die als On-Demand-Services angeboten werden.

- Zero-Trust-Rechenzentren: Einbettung identitätsorientierter Sicherheit auf jeder Ebene.

- 5G-Natives Slicing: Dedizierte Netzwerk-Slices für Colo-Mieter mit Echtzeit-QoS.

- Nachhaltigkeit als Dienstleistung: Kohlenstoff- und wasserneutrale End-to-End-SLAs mit automatischer Berichterstattung.

Colocation ist nach wie vor die Grundlage für hybride und Edge-gesteuerte digitale Architekturen, die die Kontrolle über die selbstverwaltete Infrastruktur mit den Einsparungen, Ökosystemen und Innovationen kombinieren, die durch professionelle, Carrier-neutrale Rechenzentren ermöglicht werden.

Sind Sie bereit, Ihre Colocation-Strategie zu verbessern?

Azura Consultancy's Expertise in Colocation-Rechenzentren

Azura Consultancy mit einer nachgewiesenen Erfolgsbilanz in Beratung für Rechenzentren, arbeitet mit Unternehmen in jeder Phase ihrer Reise zu einem kolokierten Rechenzentrum zusammen, beginnend mit strategische Planung und Durchführbarkeit. Wir führen eingehende Durchführbarkeitsstudien die die technische, finanzielle und betriebliche Realisierbarkeit bewerten, indem sie die Netzanforderungen, die Standortbedingungen, die Marktdynamik und die behördlichen Auflagen beurteilen, um Risiken und Chancen zu erkennen, bevor Sie sich zum Bau oder zur Miete verpflichten.

Unser technische Due-Diligence-Prüfung Praxis liefert dann unvoreingenommene Bewertungen von Energie- und KühlungsarchitekturenDie Projektentwicklung wird durch die Einhaltung von Standards, Redundanzplänen, physischen Sicherheitsmaßnahmen und Skalierbarkeit gewährleistet, so dass Ihr Projekt sowohl den Industriestandards als auch den Erwartungen der Investoren entspricht.

Für M&A- oder Finanzierungsszenarien erweitern wir diese Bewertungen zu umfassenden Lender's Due-Diligence-Beratung (LTA)-die rechtliche, wirtschaftliche und ökologische Aspekte abdecken, damit Kreditgeber und Interessengruppen fundierte Entscheidungen treffen können.

Über die Analyse im Vorfeld hinaus unterstützen Azuras Experten Businessplan-Entwicklung, Total-Cost-of-Ownership-Modellierung und Fahrpläne für die Einhaltung von Vorschriften, die Kohlenstoffabgaben, Netzzugangsgebühren und Nachhaltigkeitsziele berücksichtigen.

Unser Projektleitung Team überwacht die gesamte Lieferung - von der Auswahl der Lieferanten und der Designvalidierung bis hin zur Bauüberwachung und Inbetriebnahme - und nutzt dabei strenge Qualitätskontrollen und DCIM-Integration in Echtzeit für eine nahtlose Übergabe. Nach der Bereitstellung bieten wir eine fortlaufende Leistungsoptimierung an, indem wir PUE/WUE-Kennzahlen abstimmen, Programme zur Wiederverwendung von Kreislaufwirtschaftsgütern implementieren und Folgendes bereitstellen digital-twin-Simulationen für die Kapazitätsplanung und Disaster-Recovery-Proben, damit Ihre kollokierte Infrastruktur widerstandsfähig und effizient bleibt und mit den sich entwickelnden Geschäftszielen übereinstimmt.